За 10 лет количество этических нарушений, связанных с искусственным интеллектом, выросло в 26 раз, подсчитали аналитики AI Index Report 2023.

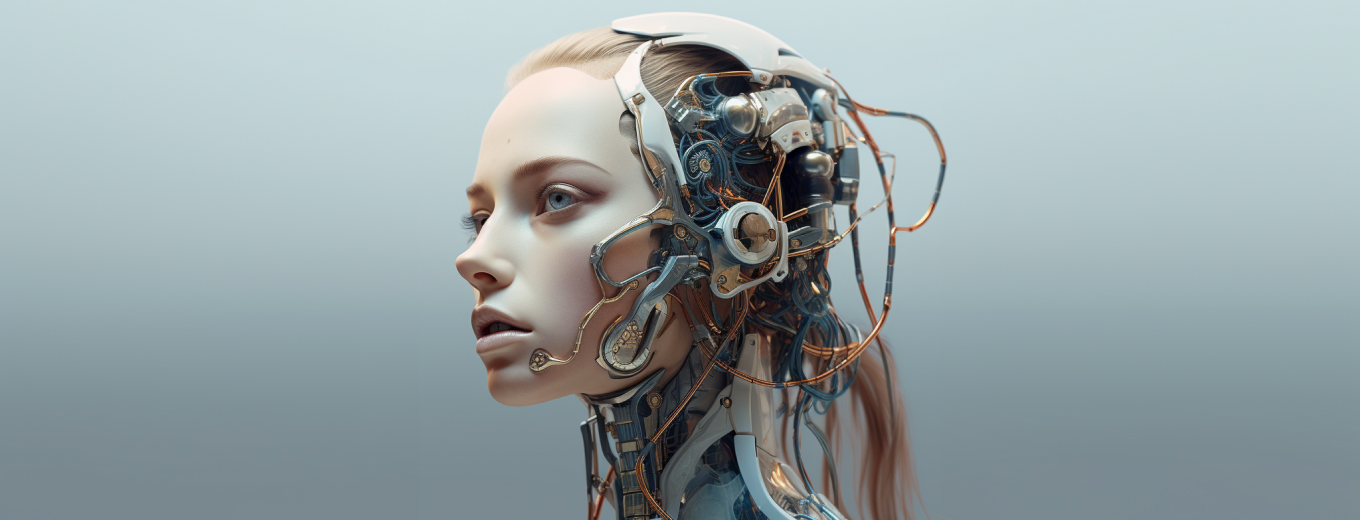

Распознать сгенерированные нейросетью изображения становится практически невозможно. Растет и многообразие самих дипфейков: если еще несколько лет назад этот термин предполагал замену лица на видео, то сейчас к ним добавили полностью сгенерированные, но правдоподобные фотографии и видео, а также имитация голоса и оригинального текста.

Рост интереса к дипфейкам совпал с бумом генеративных нейросетей, которые создают реалистичные изображения по текстовому запросу пользователя. Чтобы сгенерировать дипфейк, необязательно специально обучать нейросеть — достаточно точно сформулировать запрос.

Порой ИИ получается обмануть даже авторитетные СМИ. В марте 2023 года даже авторитетные издания начали активно распространять фотографии папы Римского в белом пуховике, и лишь спустя некоторое время выяснилось, что эти кадры были сгенерированы с помощью нейросети Midjourney.Как отличить дипфейки от реальных фото и видео, рассуждали спикеры AI-трека на форуме МТС TrueTech Day. Читайте в статье на сайте SecurityLab.ru